Apprendre les outils Webmaster de Google avec la Search Console

Accueil > Technique > Le reste > Le reste Avancé > Apprendre les outils Webmaster de Google avec la Search Console

Sujets que vous pourriez aussi aimer :Outils Google Webmaster pour le référencement

Beaucoup de règles de base sont à respecter pour référencer correctement un site Web et obtenir de bons retours par le biais des liens organiques, soit des résultats naturels que Google fournit en réponse aux demandes faites par les internautes depuis son moteur de recherche.

Communication avec Google - Google Webmaster - Search Console

Premièrement il faut établir une communication avec le robot de Google, GoogleBot, par les outils fournis aux Webmasters. Ces outils permettent de suivre toutes les anomalies, toutes les nouvelles normes, tout ce que Google n'arrive pas à indexer. Ils permettent aussi de fournir des indications et des directives à Google.

Sitemap

Un sitemap, fichier au format XML doit être fourni à Google et si possible, il doit régulièrement être mis à jour en fonction des évolutions du site. Ce Sitemap doit fournir à Google les url des pages importantes du site, soit les points d'entrée et surtout pas une ferme interminable d'url. Vous devez fournir les url des catégories principales du site, voire des sous catégories. Vous menez Google jusqu'au listing des produits et/ou articles à parcourir et à indexer. Ces pages sont généralement des pages riches qui respectent une thématique précise et dont le référencement est pertinent et simplifié du fait de la densité de mots clés. Google se chargera d'indexer les liens à suivre. En tête du sitemap, il ne faut bien sûr par oublier la page d'accueil, point d'entrée principal du site.

Le fichier XML à construire :

<urlset xmlns='https://www.google.com/schemas/sitemap/0.84'>

<url>

<loc>https://www.nom-de-domaine/</loc>

<lastmod>2014-05-14</lastmod>

<changefreq>daily</changefreq>

<priority>1.0</priority>

</url>

<url>

<loc>https://www.nom-de-domaine/beaute-c-1_page_1.html</loc>

<lastmod>2014-05-14</lastmod>

<changefreq>weekly</changefreq>

<priority>0.5</priority>

</url>

<url>

<loc>https://www.nom-de-domaine/beaute_soins-du-visage-c-1_1_page_1.html</loc>

<lastmod>2014-05-14</lastmod>

<changefreq>weekly</changefreq>

<priority>0.9</priority>

</url>

<url>

<loc>https://www.nom-de-domaine/beaute_soins-du-corps-c-1_2_page_1.html </loc>

<lastmod>2014-05-14</lastmod>

<changefreq>weekly</changefreq>

<priority>0.8</priority>

</url>

...

</urlset>

Pour une bonne indexation et compréhension du maillage par GoogleBot, entre les balises url, quatre informations importantes sur les pages sont à fournir. Tout d'abord, l'url de la page : (

<loc></loc>), la dernière modification importante (date au format anglais) qui a eu lieu (<lastmod></lastmod>), la fréquence à laquelle on demande à Google de revenir visiter la page (<changefreq></changefreq>) et enfin l'importance de la page par rapport aux autres (<priority></priority>).loc : L'url absolue de la page à visiter.

lastmod : La date de la dernière modification importante de la page. Il peut s'agir d'une modification de structure, d'ajout significatif de nouveau contenu à indexer ou tout simplement la date à laquelle vous déclarez pour la première fois la page dans le sitemap.

Changefreq : La fréquence avec laquelle vous demandez à Google de venir visiter ce point d'entrée. Attention il s'agit d'une indication fournie à Google et non d'une directive. Google reste maître de ses décisions. Quatre valeurs sont possible : Daily, Weekly, Monthly et Yearly. Une page d'accueil se visite Daily. Pour les autres, si les mises à jour sont quotidiennes et significatives en terme de contenu, Daily est acceptable. Pour des pages dont les mises à jours sont régulières Weekly est plus adapté. Pour des pages au contenu statique comme des fiches produit, ou des articles en archive Monthly voire Yearly sont plus appropriés. Toutes les changefreq des pages ne doivent pas être réglées sur la même valeur, sinon aucune ne ressort, le maillage n'est pas clair et Google ne suivra aucune consigne.

priority : Il s'agit de l'importance de la page qui varie de 0.1 à 1.0. Il s'agit d'une importance relative d'une page par rapport à l'ensemble des pages fournies dans le sitemap. C'est avec cette priority que vous indiquez à Google les points cruciaux du site. La page d'accueil, point d'entrée principal peut directement être réglée sur 1.0. Pour les autres, plus le contenu d'une page est riche, possède des liens en dur (vers rubriques, produits ) et est mis à jour régulièrement, plus son importance doit tendre vers 0.9, dans le cas contraire, elle doit tendre vers 0.1.

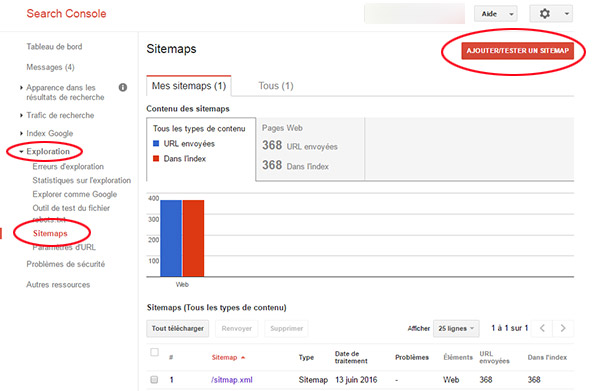

Une fois le sitemap conçu, il doit être soumis à Google.

- Le nommer sitemap.xml par exemple,

- Dans la Search Console, cliquer dans la colonne de gauche sur Exploration,

- Puis cliquer sur Sitemaps,

- Au centre de l'écran cliquer sur Ajouter/Tester un sitemap,

- Puis double cliquer sur votre sitemap sur votre ordinateur.

Robots.txt

Tout site doit avoir un fichier robots.txt à la racine. Il permet de passer des consignes à Google, notamment des interdictions pour des groupes de pages à ne pas visiter. Il s'agit aussi de la meilleure technique pour purger l'index Google des pages parasites.

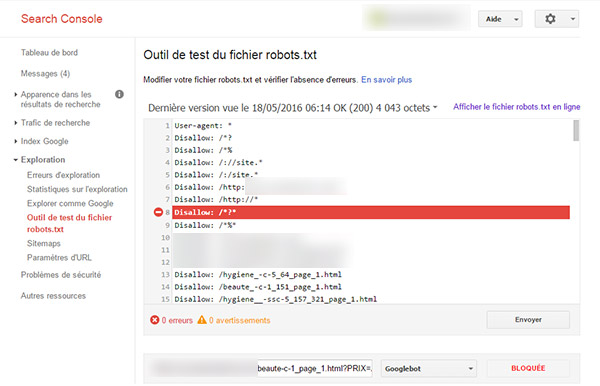

- Dans la Search Console, cliquer dans la colonne de gauche sur Exploration,

- Puis cliquer sur Outil de test du fichier robots.txt,

Ce fichier ne se soumet pas à Google par la Search Console. Il se place à la racine du site et Google vient le visiter régulièrement. Il est reconnu par son nom et doit s'appeler : robots.txt.

User-agent: * Signifie que tous les robots sont autorisés.

Disallow: / est la ligne de commande pour interdire l'indexation des pages dont la forme est celle qui suit le slash (/ : soit la forme après le nom de domaine). Par exemple ici nous interdisons l'indexation des url contenant un point d'interrogation (Disallow: /*?*), quoiqu'il y ait avant ou après ce point d'interrogation (*?*). En effet ces pages sont souvent des pages de tri qui ne modifient en rien le contenu mais seulement l'ordre, avec pourtant une url différente. Pour éviter les duplicate content interne, ces pages sont bloquées.

Les paramètres d'url :

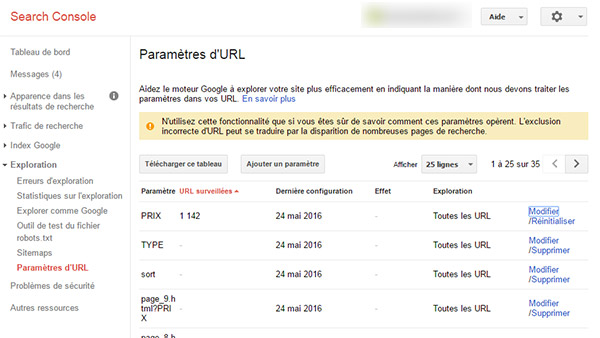

En complément du fichier robots.txt, la Search Console offre un outil efficace pour purger l'index, faciliter l'indexation et la lecture du site par Google. Les paramètres d'url sont les attributs qui modifient une url pour réaliser des tris ou des sélections restrictives sur des pages déjà référencées par Google. Il faut les exclure de l'index car elles apportent de la confusion et gonflent souvent le duplicate content.

- Dans la Search Console, cliquer à gauche sur Exploration,

- Puis cliquer sur Paramètres d'URL.

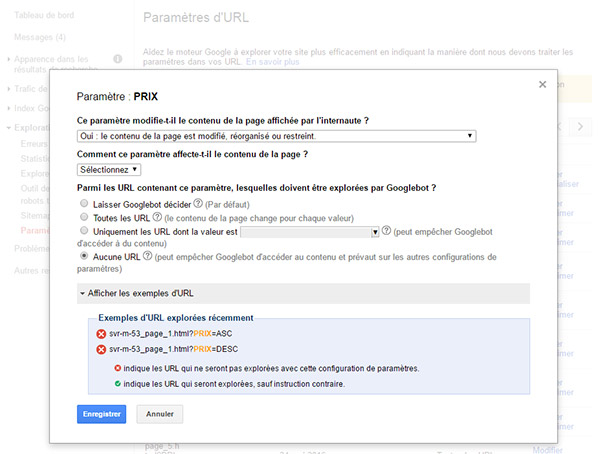

Pour indiquer à Google que ces url ne doivent être ni crawlées, ni indexées :

- Cliquer sur le lien Modifier dans la colonne de droite,

- Dans la fenêtre qui apparaît, choisir Oui, le contenu de la page... avec la liste déroulante,

- Cocher Aucune Url,

- Cliquer sur Enregistrer,

- Reproduire ces manipulations pour chacun des paramètres d'url à exclure.

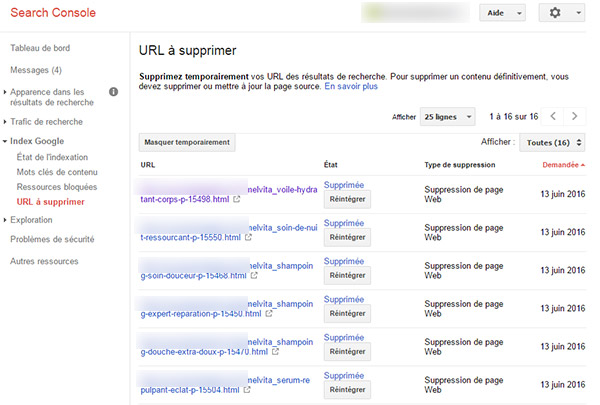

Maintenance des url - Url à supprimer :

Tout au long de la vie du site, il est important de maîtriser le flux référencé dans l'index Google. Des pages sont supprimées. Il faut certes l'indiquer dans l'entête de la page afin de fournir une réponse serveur 404 introuvable ou 301 Moved Permanently, et un noindex,nofollow dans la meta robots. Pourtant l'url va perdurer dans l'index Google. Ce dernier va visiter et revisiter la page à plusieurs reprises sur plusieurs semaines voire plus, pour en avoir la certitude. Il peut s'agir d'une erreur du serveur, d'un contenu disparu momentanément, d'une erreur du webmaster. Si les suppressions sont fréquentes, les url qui parasitent l'index et donc la qualité du référencement vont rapidement se cumuler. Pour palier le problème, il faut effectuer la demande de suprresion manuellement auprès de Google. En quelques heures, elles auront disparu définitivement, dès lors que la meta robots indique bien Noindex,Nofollow.

- Dans la colonne de gauche, déployer la rubrique Index Google,

- Dans la liste, cliquer sur Url à supprimer,

- Au centre de l'écran, cliquer sur le bouton Masquer temporairement,

- Coller l'url de la page à supprimer,

- Cliquer sur Continuer,

- Reproduire l'opération pour chaque Url à exclure définitivement.

Indexation et retour d'erreur :

Statistiques d'exploration :

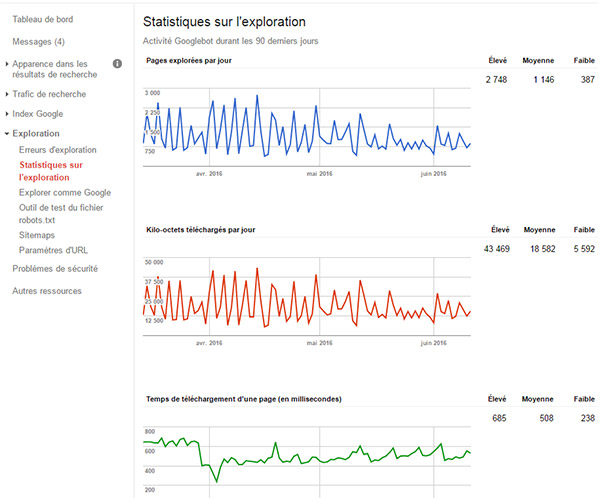

Google fournit des statistiques sur l'exploration quotidienne du site forcément étroitement liée avec son indexation. Depuis la Search Console :

- Cliquer à gauche sur Exploration,

- Puis cliquer sur Statistiques sur l'exploration,

Le graphique du dessus en bleu représente le nombre de pages explorées chaque jour. Les facteurs pour une bonne exploration du site sont son ancienneté, la clareté de son maillage et les temps de réponse du serveur. Le graphique du dessous en vert représente les temps de téléchargement d'une page (liés aux temps de réponses). Si vous observez des chutes récurrentes dans le graphique en bleu, assurez vous qu'ils ne correspondent pas dans le même temps à des pics sur le graphique en vert. Plus le temps de réponse est long, plus l'exploration en souffre.

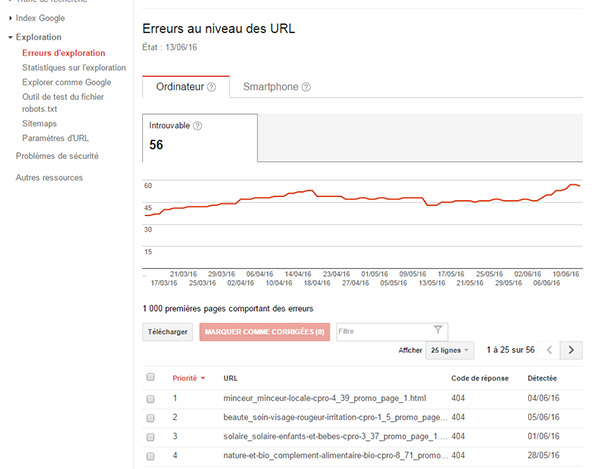

Erreurs d'exploration :

- Dans la Search Console, cliquer à gauche sur Exploration,

- Puis cliquer sur Erreurs d'exploration,

Surveillez ici que le nombre d'erreurs remonté n'est pas en constante progression et qu'elles sont justifiées (pages supprimées, bloquées par robots.txt). Dans le cas contraire, vérifiez le maillage du site, qu'il ne propose pas des pages obsolètes liées en dur (href), la qualité de l'hébergeur, les temps de réponse.

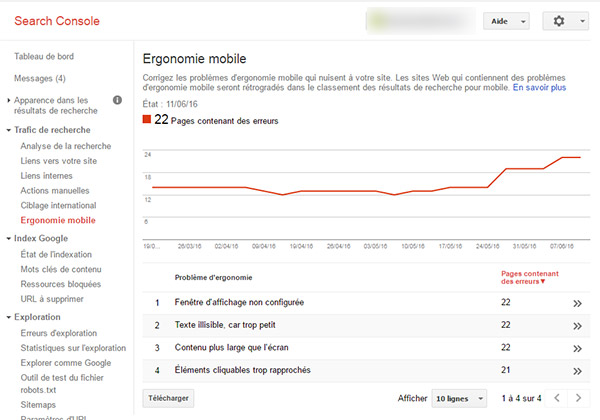

Ergonomiemobile :

Votre site doit bien sûr être responsive. Son ergonomie doit s'adapter à tous les supports (Pc, tablette, Smartphone). La Search Console propose plusieurs rubriques permettant de réaliser un suivi.

- Dans la colonne de gauche de la Search Console, cliquer sur Trafic de recherche,

- Puis cliquer sur Ergonomie mobile.

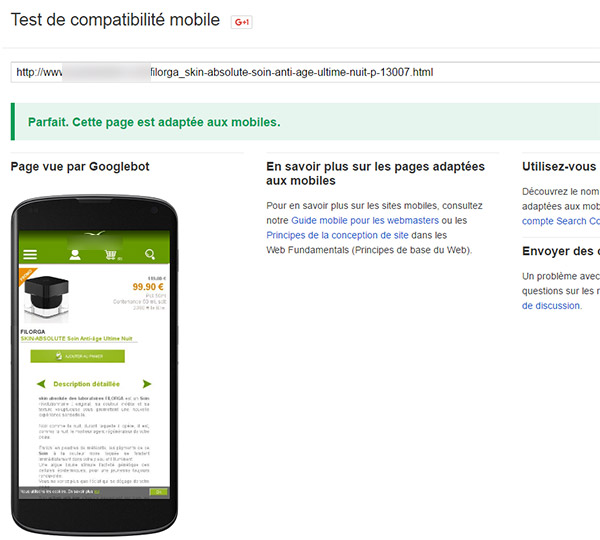

Pour tester si vos pages sont mobile friendly, rendez-vous ici : https://www.google.com/webmasters/tools/mobile-friendly/?hl=fr

Vous arrivez sur la page de test de compatibilité mobile de Google.

- Coller l'url de la page à tester dans la zone de saisie,

- Cliquer sur Analyser.

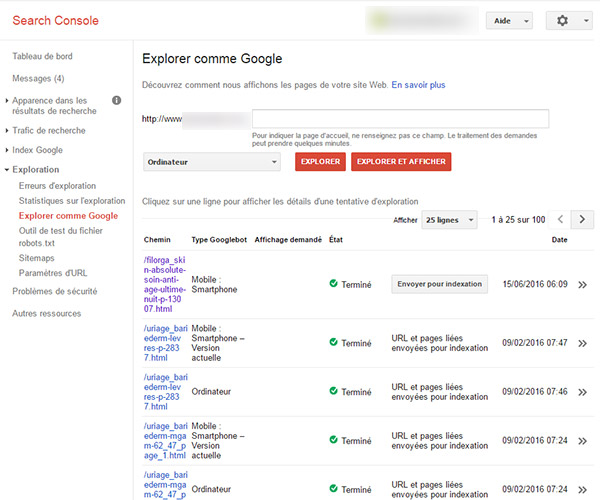

Explorer comme Google :

- Dans la section de gauche, cliquer sur Exploration,

- Dans la liste déployée, cliquer sur Explorer comme Google.

- Coller l'url de la page à tester dans la zone de saisie (Sans le nom de domaine),

- Choisir la plateforme (Ordinateur, Mobile...) à l'aide de la liste déroulante,

- Cliquer sur le bouton Explorer.

Vous pouvez ensuite cliquer sur le lien de la page qui apparaît dans la synthèse du dessous. Vous accédez au code source tel que le visualise GoogleBot. Si cette page est importante et/ou qu'elle a subi des évolutions conséquentes, vous pouvez la soumettre à indexation pour accélérer le processus de référencement en cliquant sur le bouton Envoyer pour indexation. A reproduire pour chaque url et chaque plateforme. Vous pouvez ainsi espérer retrouver votre page plus rapidement dans les résultats de recherche.